- DeepSeek一体机

- 搭载NVIDIA GPU算力卡

- 搭载国产GPU算力卡

- 北京算力租赁

- 专有网络VPC

- 通过专线/VPN/GRE等方式构建混合云网络

- 负载均衡SLB

- 对多台服务器进行流量分发,消除单点故障

- 物联网无线连接

- 物联网卡,如:车联网、智能家居等

- SD-WAN服务

- 数据中心之间互联DCI

- 企业上云专线

- 跨国企业组网

- 免费试用

- 大数据解决方案

- 个性化推荐解决方案

- 大数据仓库解决方案

- 数字营销解决方案

- 企业数据服务解决方案

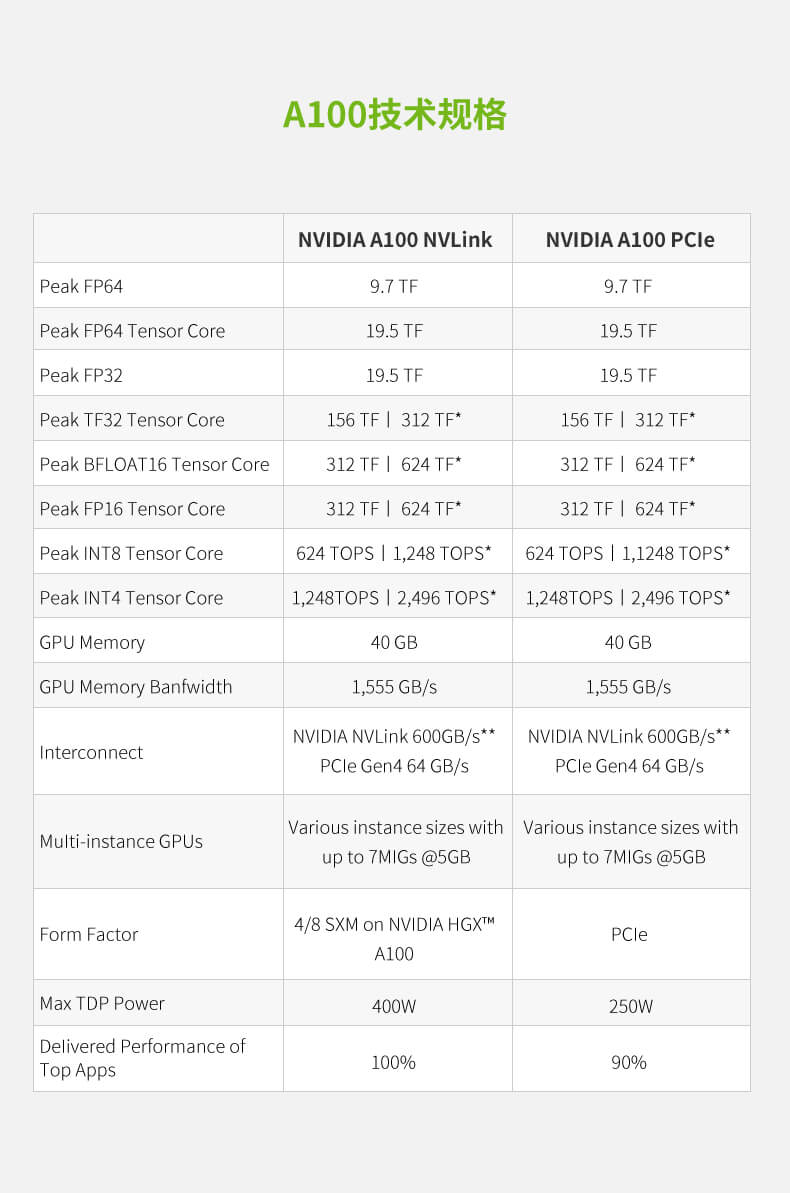

极强大的端到端 AI 和 HPC 数据中心平台

A100 是完整 NVIDIA 数据中心解决方案的一部分,该解决方案结合了跨硬件、网络、软件、库以及 NGC™ 的经过优化的 A1 模型和应用程序的构建块。 它代表了强大的数据中心端到端 AI和 HPC平台,使研究人员可以提供真实的结果并将解决方案大规模部署到生产中。

深度学习训练

NVIDIA A100 的 Tensor Core 借助 Tensor 浮点运算(TF32)精度,可提供比上一代NVIDIA Volta 高 20 倍之多的性能,并且无需更改代码;若使用自动混合精度和 FP16,性能可进一步提升2倍。与 NVIDIA®NVLink®、NVIDIANVSwitch"、PCI4.0、NVIDIA® Mella-nox® InfiniBand®和 NVIDIA Magnum IO" SDK结合使用时,可扩展到数千个 A100 GPU。 2048 个A100 GPU 可在一分钟内大规模处理 BERT之类的训练工作负载,这是训练时间的世界纪录。 对于具有庞大数据表的超大型模型(例如用于推荐系统的 DLRM),A10080GB可为每个节点提供高达 1.3 TB 的统一显存,而且速度比 A100 40GB 快高达 3倍。 NVIDIA 产品的领先地位在 MLPerf 这个行业级 AI 训练基准测试中得到印证,创下多项性能纪录。

高性能数据分析

搭载 A100NVIDIA® NVLink® and NVSwitch" 实现的超快速内存带宽(超过每秒2TB)和可扩展性妥善处理工作负载。通过结合 InfiniBand,NVIDIAMagnumI0™和 RAPIDS™ 开源库套件(包括用于执行 GPU 加速的数据分析的 RAPIDS AcceleratorforApache Spark),NVIDIA 数据中心平台能够加速这些大型工作负载,并实现超高的性能和效率水平。

中国互联网信息中心(CNNIC)IP地址分配联盟成员 北京市通信行业协会会员单位 中国互联网协会会员单位

跨地区增值业务经营许可证(A2.B1-20150255) 电信与信息服务业务经营许可证(京ICP证060342号) 京ICP备05032038号-1 京公网安备11010802020193号

Copyright ©2005-2024 北京互联互通科技有限公司 版权所有