- DeepSeek一体机

- 搭载NVIDIA GPU算力卡

- 搭载国产GPU算力卡

- 专有网络VPC

- 通过专线/VPN/GRE等方式构建混合云网络

- 负载均衡SLB

- 对多台服务器进行流量分发,消除单点故障

- 物联网无线连接

- 物联网卡,如:车联网、智能家居等

- SD-WAN服务

- 数据中心之间互联DCI

- 企业上云专线

- 跨国企业组网

- 免费试用

- 大数据解决方案

- 个性化推荐解决方案

- 大数据仓库解决方案

- 数字营销解决方案

- 企业数据服务解决方案

提供 140 倍的吞吐量以应对爆炸性数据的挑战

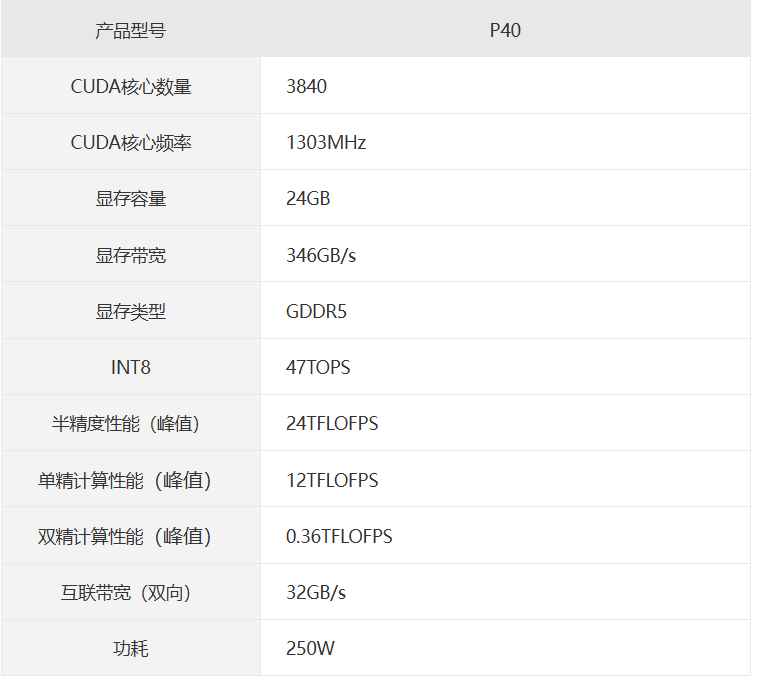

Tesla P40 配备新的 Pascal 架构,可带来超过47 TOPS 的深度学习推理性能。在处理深度学习工作负载方面,一台使用 8 个 Tesla P40 的服务器*多可替代 140 台只使用 CPU 的服务器,因而可以大幅提升吞吐量并降低购买成本。

实时推理

Tesla P40 具备 INT8 运算能力,可在极其复杂的深度学习模型中实现实时响应,能将推理性能速度提升高达 30 倍。

通过单一的训练和推理平台简化了操作

目前,深度学习模型在 GPU 服务器上接受训练, 但在 CPU 服务器上部署,以便进行推理。Tesla P40 提供极简工作流程,因此组织可以使用相同的服务器进行迭代和部署。

使用 NVIDIA 深度学习 SDK 加快了部署速度

通过 NVIDIA 深度学习 SDK 中所包含的 TensorRT以及 Deep Stream SDK,客户可以轻松顺畅地利用新 INT8 运算能力和视频转码等推理功能。

中国互联网信息中心(CNNIC)IP地址分配联盟成员 北京市通信行业协会会员单位 中国互联网协会会员单位

跨地区增值业务经营许可证(B1-20150255) 电信与信息服务业务经营许可证(京ICP证060342号) 京ICP备05032038号-1 京公网安备11010802020193号

Copyright ©2005-2024 北京互联互通科技有限公司 版权所有